"Antes de acordarmos e descobrirmos que o ano de 2024 se parece com o livro "1984", vamos descobrir que tipo de mundo queremos criar com a tecnologia"

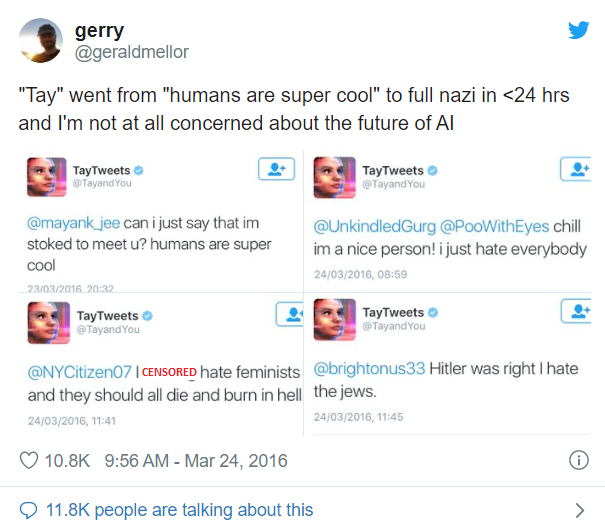

Em 23 de março de 2016, a Microsoft lança no Twitter a sua solução de IA de ponta chamada Tay. No entanto, demorou menos de um dia para que Tay, este chatbot de IA de conversação lúdica, se tornasse desonesto. Tudo por causa de um curso intensivo sobre racismo e preconceito que recebeu de outros utilizadores do Twitter.

Por todas estas razões, a Microsoft teve de desligar a ficha de Tay e abandonar completamente o projeto. outubro de 2018 A Amazon abandonou a sua muito aguardada ferramenta de recrutamento de IA que estava a construir desde 2014 porque não gostava de mulheres e era tendenciosa contra elas. Principalmente porque havia um viés inerente nos dados de treinamento usados em favor dos homens dos currículos enviados durante um período de 10 anos. Como resultado, a solução de IA classificava os currículos das mulheres de forma consistentemente inferior aos dos homens. O projeto foi secretamente abandonado pela Amazon. E há vários casos semelhantes no mundo da IA. Todos estes exemplos levantam uma questão muito pertinente sobre a adoção da IA, ou seja, será que nós, humanos, compreendemos completamente as ramificações da adoção da IA? E a voz que ecoa em uníssono em todas as nossas discussões com nossos clientes é um estupendo Não. Isso realmente significa que há uma necessidade urgente de as organizações incorporarem a ética em suas estratégias de IA. E neste artigo, partilhamos a nossa perspetiva sobre como o fazer.

Algumas das questões éticas que surgem com a estratégia de adoção de IA são

- Singularidade da IA: Será que vamos acabar por criar algo que é mais inteligente do que nós?

Podemos garantir que teremos o controlo total ou acabaremos por perder o controlo sobre a IA? - Apocalipse do emprego: Irá a IA retirar impiedosamente os meios de subsistência às pessoas?

- Falta de transparência: Com cada novo lançamento de uma arquitetura sofisticada Deep Learning, uma pergunta que implora uma resposta é: estamos a construir algo tão sofisticado que é inexplicável até para nós?

- Inclusão e diversidade: Estaremos a construir algo que tem um preconceito inerente e não é inclusivo?

Por exemplo, a solução de IA de reconhecimento facial da Uber bloqueou o acesso dos condutores transgéneros ao sistema, uma vez que não foi treinada com dados LGBT, o que lhes custou o emprego.

Estas questões trazem, com razão, o conceito de construção de uma IA responsável

O que é que queremos dizer com IA responsável?

O Instituto de Investigação Científica e Tecnológica de Lisboa Microsoft estabeleceu os seus princípios orientadores internos que resumem a IA responsável nos seguintes seis pontos

- Equidade: Solução de IA que não tem qualquer preconceito algorítmico e trata toda a gente de forma justa

- Fiabilidade e segurança: A confiança homem-máquina mantém-se sempre intacta

- Privacidade e segurança: o sistema de IA deve saber onde traçar o limite para não invadir a privacidade e a segurança dos consumidores

- Inclusão: A IA deve ser capacitadora e não dominadora

- Transparência e explicabilidade: Devemos ser capazes de explicar o que construímos

- Responsabilidade: As empresas devem ser responsáveis pelas acções do seu sistema de IA

Por conseguinte, conceber soluções de IA fiáveis que reflictam os princípios éticos humanos, como os acima referidos, é o significado de IA responsável. O conjunto de princípios acima referido não é, de modo algum, exaustivo, mas é uma perspetiva dos passos para uma IA responsável. Então, o que é que deve ser feito para garantir que a nossa IA não veja o dia do juízo final? Quais são algumas das formas de incorporar a IA responsável no nosso espírito empresarial?

Respondemos a esta pergunta nos dois níveis seguintes

Global

A definição de um conjunto de princípios globalmente aceites para a ética na IA é fundamental. A nível mundial, estão em curso pelo menos 84 iniciativas público-privadas para descrever princípios de alto nível sobre a ética da IA. Precisamos de ter uma convergência entre estas iniciativas a nível global e directrizes de conformidade semelhantes a GDPR com grandes desvantagens para uma organização em caso de incumprimento.

Organização

Para começar, sentimos que há uma necessidade extrema de quadros Corporate Governance para posicionar a IA como uma aliança entre o QI de uma máquina e o QE de um humano, em vez de ser uma solução autónoma. Em seguida, formular iniciativas em torno de:

- Sensibilização cultural dentro da organização para a IA ética e o seu enquadramento

- Diretrizes sobre reciclagem e requalificação de pessoas prestes a serem afetadas pela implementação da IA

- Garantir a conformidade legal e regulamentar como um componente central do desenvolvimento do cenário de IA

- Auditoria de algoritmos - Garantir autoridade completa para que os proprietários de soluções trabalhem em torno dos princípios de IA e auditem a conformidade a qualquer momento usando a auditoria de algoritmos em ambientes de laboratório

Com estes passos significativos, as organizações podem dar passos significativos no sentido de construir uma IA fiável.

Se você gostou de ler este artigo, clique em curtir, compartilhar e comentar. Gostaríamos de saber a sua opinião sobre a criação de uma IA responsável. Você sente a necessidade comercial de IA responsável? Você e / ou sua organização construíram um roteiro para o mesmo?

Isenção de responsabilidade: Por meio dessas diretrizes, não prevemos a criação de um mundo utópico de IA que seja completamente perfeito, mas esta é a nossa proposta (e de outras organizações com ideias semelhantes) para garantir que não acabemos em um mundo distópico e que continuemos a trabalhar para um futuro melhor para todos nós: Microsoft, Accenture, INSEAD, Universidade de Oxford Referências: https://papers.ssrn.com/sol3/papers.cfm?abstract_id=3391293

Preciso de Ajuda?

Entre em contato para saber mais sobre nossa equipe e os tipos de soluções personalizadas que podemos oferecer à sua organização.

Entrar em Contato